Как ChatGPT понимает мемы. Нейросеть объяснила мем с Винни-Пухом в смокинге, но не поняла шрифт Lobster

ChatGPT проанализировал мемы по картинкам. Чат-бот на основе нейросети объяснил смысл пикчи с Винни-Пухов в элегантном костюме, разглядел абсурдность изображения с летящим котом, но не распознал шрифт Lobster.

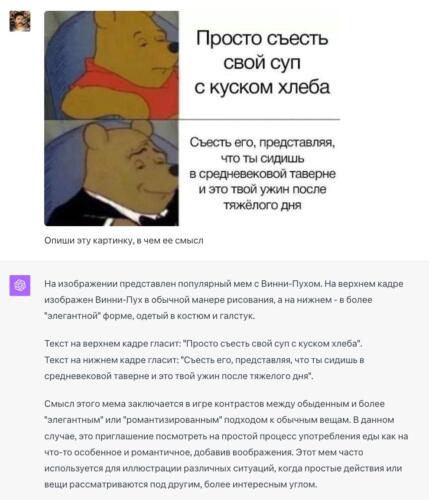

Автор канала AI molodca Александр Доброкотов протестировал возможности нейросети ChatGPT 4, которой теперь можно показывать картинки. Блогер проверил, как искусственный интеллект понимает мемы. Например, GPT 4 хорошо описал, в чём суть популярного мема с Винни-Пухом в элегантном костюме — в контрасте между <<обыденным и романтизированном подходе к обычным вещам.

Как выяснил Доброкотов, нейросеть не всегда считывает, что у картинки есть двойной смысл. Так, GPT 4 объяснил, что комичность мема с собаками в машине заключается в том, что животным приписываются человеческие черты. Но шутку про дальтонизм у собак искусственный интеллект различил только после подсказки.

ChatGPT может распознать, когда суть мема в абсурдности изображения — например, с сосиской, к которой <<подключен>> провод от зарядки.

Нейросеть уловила суть абстрактного мема с котом, летящим на стуле в Таджикистан. Однако не обратила внимание, что название страны специально написано с ошибкой, чтобы придать дополнительный комический эффект. <<Таджикистон>> можно интерпретировать как эрратив (слово с намеренной орфографической ошибкой) или как каламбур — в топоним вписали слово <<стон>>, потому что кот на картинке будто бы кричит или стонет.

По наблюдениям автора AI molodca, чат-бот с трудом распознаёт шрифт Lobster. Например, на картинке про фрилансера вместо фразы <<Эстетика фриланса>> нейросеть прочитала <<Эсмемчика фришанса>> (что, по мнению редакции TKSAG, ещё смешнее). Однако ошибка не помешала чату понять смысл мема.

Анализируя мемы, GPT 4 видит различные приёмы, которые используют люди для создания комического эффекта. Например, преувеличение (или гиперболу) в пикче про влияние количества часов сна на состояние человека.

В ходе эксперимента GPT не один раз ошибся с анализом популярного мема, в котором человек на велосипеде вставляет палку в свои же колёса и падает. На картинке представлен видоизменённый мем, где ездок без происшествий проезжает по дороге — юмор и заключается в несоответствии оригиналу. Тем не менее, нейросеть описала первоначальный вариант. Блогер предположил, что ИИ просто сравнивает изображение с базой данных и без анализа отличающихся деталей просто выдаёт готовый ответ.

Хотя ChatGPT 4 допускает ошибки, по мнению Доброкотова, с задачей по больше части справляется на неплохом уровне.

Ранее TKSAG рассказывал, как ChatGPT сгенерировал рецепт пасты по фото продуктов, которые остались в холодильнике.

tksag.ru

tksag.ru