Facebook решил доверить процесс отбора новостей алгоритмам и спровоцировал распространение фейковых публикаций из сомнительных источников.

В августе этого года Facebook объявил, что новости для сайта больше не будут писать люди. Компания заменила редакторов на алгоритмы после обвинения в политической дискриминации и с тех пор полностью автоматизировала процесс. Однако буквально через три дня после введения новой системы некорректно сгенерированный заголовок одной из новостей вызвал скандал.

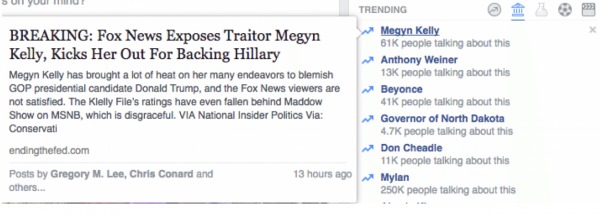

В разделе <

В ходе него издание три недели анализировало статьи, которые генерируют алгоритмы Facebook. С тех пор в разделе Trending много раз появлялись <<фальшивые>> новости. Результаты показали, что за это время пять популярных статей оказались абсолютной неправдой, а в трёх были серьёзные фактические ошибки. Кроме того, в колонке новостей постоянно появлялись ссылки на онлайн-сервисы (например, iTunes) и записи в блогах. Facebook отказался от комментариев, сообщает издание. Однако один из бывших сотрудников соцсети сообщил анонимно, что это было предсказуемо.

Меня совсем не удивляет количество фальшивых историй. Все, кто видел код программы и хоть как-то работал с ней, предполагали, что так и будет.

За время эксперимента журналисты обнаружили в отделе <<Популярное>> новости с сайтов открыто сатирических изданий, сомнительных медицинских организаций и таблоидов.

Изначально процесс отбора информации в отдел Trending выглядел следующим образом. Один алгоритм собирал по сети интересные темы, затем редактор изучал их и отбирал стоящие, после чего уже другой алгоритм <<рассылал>> новости на страницы тех людей, кому они могут быть наиболее интересны.

Однако в мае Facebook обвинили в политической дискриминации. Один из бывших сотрудников признался, что команда, работающая над разделом Trending, специально игнорировала новости, которые заинтересовали бы консерваторов.

После этого систему решили пересмотреть, окончательно исключив из неё человеческий фактор. Теперь в подборку входила любая новость, на которую ссылались как минимум три другие статьи, независимо от источника.

Несмотря на все скандалы и очевидные недостатки программы, представители Facebook отказываются признать свою ошибку, сообщает издание. Напротив, систему отбора дополняют всё более и более усовершенствованными алгоритмами.

Ранее TKSAG писал о том, как блогеры поверили в фейк о том, что хештег #ТрампПобедил запустили в России.

tksag.ru

tksag.ru